科金社2025年07月31日 13:21消息,微软发布DragonV2.1模型,提升语音转录自然度,错误率下降12.8%,支持100+语言合成。

2025年7月31日,科技媒体NeoWin今日发布文章称,微软近日推出了DragonV2.1Neural零次学习模型,该模型能够在仅使用少量数据的情况下生成更加自然且富有表现力的声音,并支持超过100种语言。

这是一种零次学习的文本到语音(TTS)模型,旨在提供更加自然和富有表现力的声音,同时提升了发音的准确性,并增强了对生成语音的控制能力。该技术的推出,标志着语音合成领域在智能化和个性化方面迈出了重要一步,为未来的语音交互体验带来了更多可能性。

新模型仅需几秒钟的语音样本,就能合成超过100种语言的语音。相较之下,之前的DragonV1模型在处理专有名词时存在发音不准的问题。而DragonV2.1模型则具备更强的适应性,能够应用于多种场景,例如定制聊天机器人的声音,或是为视频内容进行多语言配音。 从技术发展的角度来看,语音合成的进步不仅提升了用户体验,也为全球化内容传播提供了更高效的工具。尤其是在多语言环境下,这种技术的突破有助于减少人工成本,提高内容制作的灵活性。不过,随着技术的普及,如何确保语音合成的自然度和准确性,仍然是需要持续优化的方向。

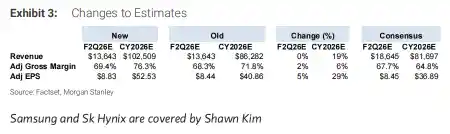

微软表示,DragonV2.1在发音准确性方面有了显著提升,相较于DragonV1,该模型的单词错误率(WER)平均下降了12.8%。这一进步表明语音识别技术正在持续优化,用户在使用过程中将获得更精准的识别体验。从实际应用角度看,这样的改进有助于提升语音助手、语音转文字等场景的效率与可靠性,为用户带来更流畅的交互体验。

该模型在声音自然度方面进行了优化,用户在使用时可以通过SSML音素标签和自定义词典对发音和口音进行更精细的控制。为了帮助用户更好地上手,微软推出了Andrew、Ava和Brian等多个声音档案,方便用户进行测试与体验。 从技术角度来看,这种对语音生成细节的增强,体现了语音合成技术在真实感和可控性上的进一步突破。通过提供多样化的预设声音和灵活的自定义选项,微软不仅降低了用户的使用门槛,也为更多个性化应用场景提供了可能。这种改进对于需要高质量语音输出的行业,如教育、娱乐和客服等,具有重要意义。

留言评论

(已有 0 条评论)暂无评论,成为第一个评论者吧!