科金社2025年09月01日 13:21消息,美团发布开源混合专家模型,5600亿参数仅激活5%即显高效性能。

9月1日消息,美团正式推出其自主研发的LongCat-Flash-ChatAI模型,并同步进行开源。该模型采用创新性的混合专家(MoE)架构,总参数量达到560B(即5600亿),在实际应用中激活的参数规模为18.6至31.3B,平均约为27B,从而在提升性能的同时显著优化了计算效率。 这一技术突破体现了企业在大模型研发上的持续投入与创新,尤其是在资源利用和效率平衡方面展现出较强的工程能力。开源举措也有助于推动行业生态的发展,促进更多开发者和研究者参与其中,进一步释放模型的潜力。

美团声称,根据多项基准测试的综合评估,作为一款非思考型基础模型,LongCat-Flash-Chat在仅启用少量参数的情况下,性能即可达到当前主流先进模型的水平,尤其在智能体任务中展现出显著优势。

同时,由于在推理效率方面的设计和创新,LongCat-Flash-Chat展现出显著更快的推理速度,更适用于需要长时间运行的复杂智能体应用。

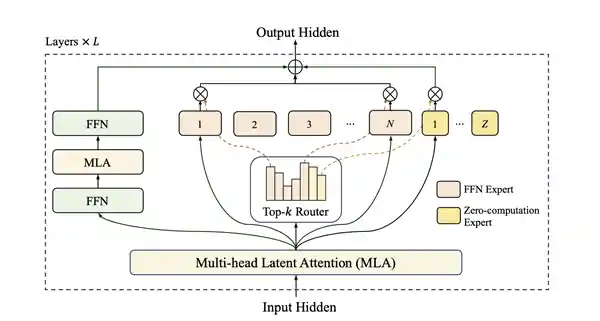

美团LongCat-Flash在架构设计中引入“零计算专家”机制,总参数规模达到560B,每个token根据上下文需求仅激活18.6-31.3B参数,实现算力的按需分配与高效使用。

为降低整体算力消耗,训练过程中采用PID控制器对专家偏置进行实时调整,使每个token的平均激活量维持在约27B左右。

此外,LongCat-Flash在层间铺设跨层通道,使MoE的通信和计算能很大程度上并行,极大提高了训练和推理效率。

配合定制化的底层优化,LongCat-Flash在30天内实现了高效训练,并在H800 GPU上达到单用户100 tokens/s的推理速度。

LongCat-Flash 对常见的大模型组件和训练方法进行了优化,采用了超参数迁移与模型层级叠加的训练方式,并融合了多种策略以提升训练的稳定性,从而确保整个训练过程高效且顺畅。

针对智能体(Agentic)能力,LongCat-Flash自建了Agentic评测集指导数据策略,并在训练全流程进行了全面的优化,包括使用多智能体方法生成多样化高质量的轨迹数据等,实现了优异的智能体能力。

通过算法与工程的协同优化,LongCat-Flash在理论层面实现了成本和速度的显著提升,其表现优于同规模乃至更小规模的行业模型。

通过系统优化,LongCat-Flash在H800平台上实现了每秒生成100个token的效率,同时每百万token的输出成本低至5元。

LongCat-Flash架构图

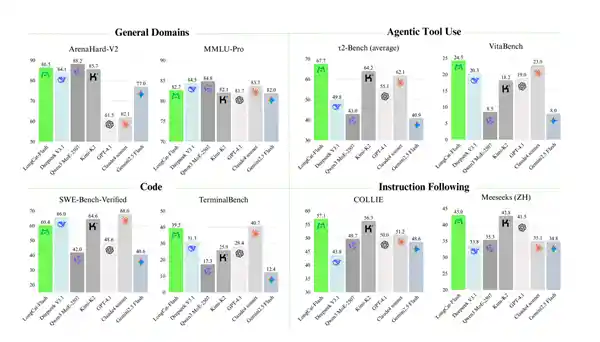

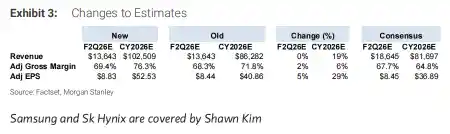

在通用领域知识方面,LongCat-Flash在ArenaHard-V2测试中取得了86.50的出色成绩,排名位列所有参评模型中的第二位。

在基础基准测试中,MMLU(多任务语言理解基准)得分为89.71,CEval(中文通用能力评估基准)得分为90.44。这些数据反映出当前模型在多任务理解和中文语言处理方面具备较强的综合能力。从评测结果来看,模型在不同语言和任务场景下的表现较为均衡,显示出良好的泛化能力和技术成熟度。这样的成绩也为后续的优化和应用提供了坚实的基础。

这些成果可以与当前国内领先的模型相媲美,且其参数量少于DeepSeek-V3.1、Kimi-K2等产品。

智能体工具使用方面,LongCat-Flash即便与参数规模更大的模型相比,在τ2-Bench(智能体工具使用基准)中的表现仍超越其他模型;高复杂度场景下,在VitaBench(复杂场景智能体基准)中以24.30分位列第一。

编程方面,LongCat-Flash在TerminalBench基准测试中以39.51分的成绩排名第二,在SWE-Bench-Verified测试中取得了60.4分的成绩。这些数据反映出该模型在命令行任务和软件工程能力方面具备较强的实力,尤其在与同类模型的竞争中表现不俗。可以看出,LongCat-Flash在实际应用和代码生成方面已经达到了较高的水平,未来有望在更多专业场景中发挥作用。

在指令遵循评估方面,LongCat-Flash在IFEval基准中以89.65分位居榜首,在中文指令遵循基准COLLIE和中文多场景指令基准Meeseeks-zh中的得分分别为57.10和43.03。

LongCat-Flash基准测试性能

美团同步提供了分别基于SGLang和vLLM的两种高效部署方案。

以下为使用SGLang进行单机部署的示例:

python3 -m sglang.launch_server \

--model meituan-longcat/LongCat-Flash-Chat-FP8 \

--trust-remote-code \

--attention-backend flashinfer \

--enable-ep-moe \

--tp 8

现在前往https://longcat.ai/ ,就能立即与LongCat-Flash-Chat开启对话。

开源平台地址:

Hugging Face:

https://huggingface.co/meituan-longcat/LongCat-Flash-Chat

Github:

https://github.com/meituan-longcat/LongCat-Flash-Chat

开源仓库统一采用MIT License,并允许用户使用模型输出内容,或通过模型蒸馏等技术训练其他模型。这一政策为开发者和研究者提供了更大的灵活性和自由度,有助于推动技术的快速迭代与应用落地。在当前AI技术日益普及的背景下,开放源代码与共享成果已成为行业共识,MIT License的广泛适用性也进一步降低了技术使用的门槛。这种开放态度不仅促进了技术创新,也为更多人参与AI发展提供了可能。

留言评论

(已有 0 条评论)暂无评论,成为第一个评论者吧!