科金社2025年07月31日 14:02消息,通义千问发布Qwen3-30B-A3B-Thinking-2507,开启推理新纪元,智启未来新篇章。

7 月 31 日消息,阿里通义千问团队今日正式推出全新推理模型 Qwen3-30B-A3B-Thinking-2507,引发业界广泛关注。作为对今年 4 月 29 日开源的 Qwen3-30-A3B 模型的全面升级,这款新模型在推理能力、通用任务表现以及上下文处理能力方面实现了显著突破,标志着国产大模型在复杂任务处理领域的持续进阶。

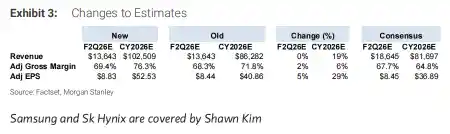

值得关注的是,Qwen3-30B-A3B-Thinking-2507 在关键推理评测中表现亮眼:在聚焦数学推理能力的 AIME25 测评中取得 85.0 的高分,在代码生成与执行能力测试 LiveCodeBench v6 中也斩获 66.0 分。这两个成绩不仅超越了此前表现不俗的 Gemini2.5-Flash(thinking),也优于参数规模更大的 Qwen3-235B-A22B(thinking),显示出其“小而精”的技术优势。这说明,模型性能的提升已不再单纯依赖参数堆砌,而更多体现在架构优化、训练策略和推理机制的深度打磨上。

在通用能力方面,该模型同样展现出全面领先的态势。无论是写作能力(WritingBench)、智能体交互能力(BFCL-v3),还是多轮对话理解与多语言指令遵循(MultiIF),Qwen3-30B-A3B-Thinking-2507 均优于同类竞品。这意味着它不仅能“算得准”“写得对”,更能“聊得深”“懂得多”,具备更强的场景适应力和用户交互潜力。从技术演进角度看,这种从“单一能力突破”向“综合智能跃升”的转变,正是大模型走向实用化的重要标志。

此次升级另一大亮点是上下文长度的大幅扩展——新模型原生支持高达 256K tokens,且具备扩展至 1M tokens 的潜力。这一能力对于处理长文档分析、代码库理解、法律合同审查等实际应用场景具有重要意义。尤其在当前信息密度不断上升的背景下,长上下文已成为衡量大模型实用价值的关键指标之一。阿里此次在上下文长度上的突破,无疑为行业树立了新的技术标杆。

值得一提的是,官方特别强调新模型的“思考长度”(thinking length)有所增强,建议在面对高度复杂的推理任务时,适当增加思考预算以释放其全部潜力。这一设计思路借鉴了“思维链”(Chain-of-Thought)与“推理时扩展”(reasoning-time scaling)的前沿理念,意味着模型具备更强的自主推理与问题拆解能力。这种“慢思考”模式的引入,或将推动大模型从“快速应答者”向“深度思考者”转型。

目前,Qwen3-30B-A3B-Thinking-2507 已在魔搭社区与 HuggingFace 平台正式开源,同时上线 Qwen Chat 供公众体验。其轻量级设计使得在消费级硬件上实现本地部署成为可能,极大降低了开发者与研究者的使用门槛。这一举措不仅体现了阿里在开源生态建设上的持续投入,也为中小企业、高校科研团队提供了高性价比的技术工具,有助于加速AI应用的普惠化进程。

综合来看,Qwen3-30B-A3B-Thinking-2507 的发布不仅是通义千问技术路线的一次重要迭代,更是中国大模型产业在高效推理、长上下文理解与本地化部署方向上取得实质性进展的缩影。在全球大模型竞争日益激烈的当下,阿里选择以“小模型+强推理”路径突围,展现出一条不同于盲目追求参数规模的理性发展思路。未来,如何在保持高性能的同时进一步降低部署成本、提升推理效率,仍将是行业共同面临的挑战,而 Qwen 的这次升级,无疑提供了一个值得参考的技术范本。

留言评论

(已有 0 条评论)暂无评论,成为第一个评论者吧!